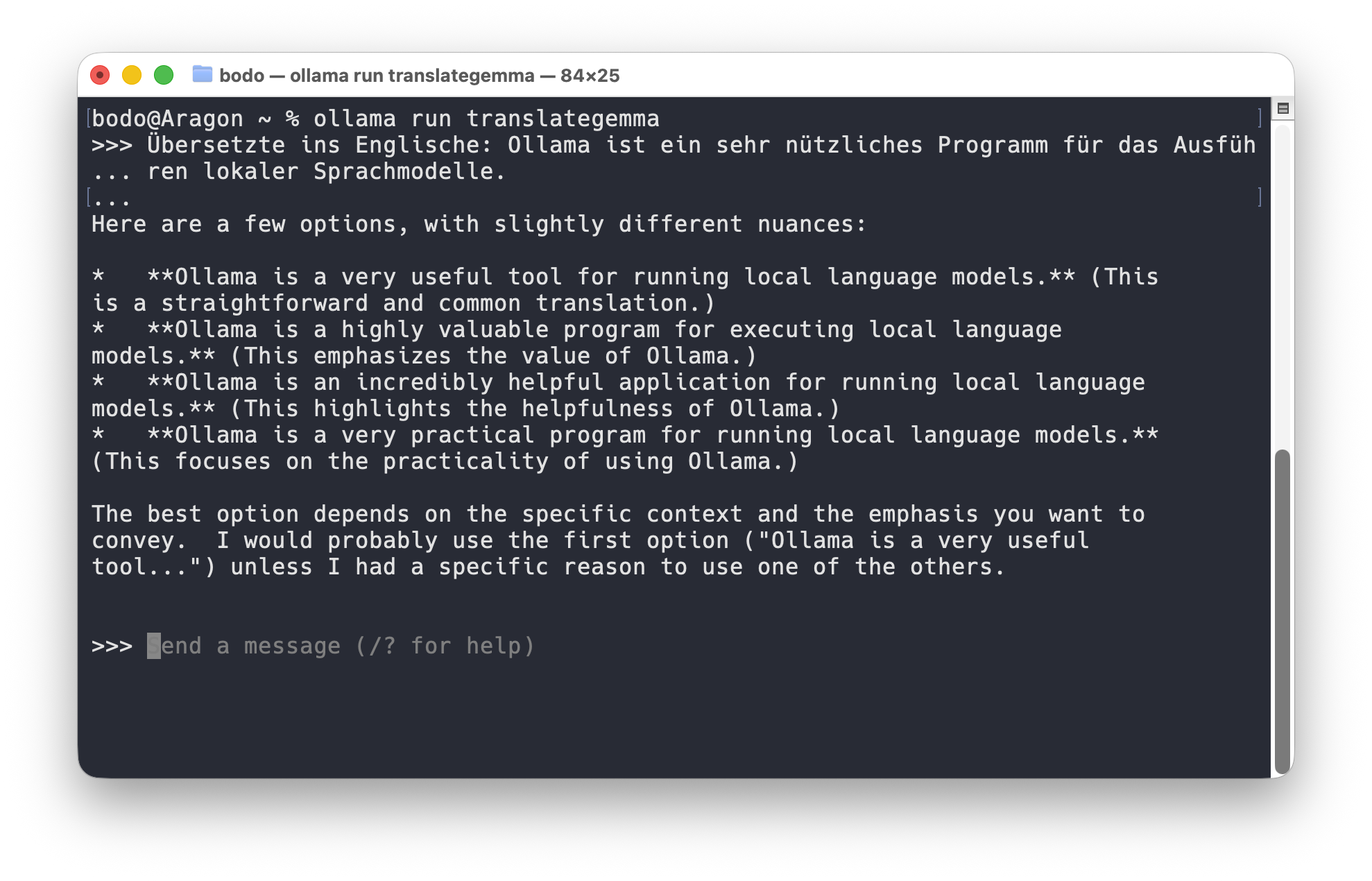

Sprachübersetzung mit Ollama und TranslateGemma

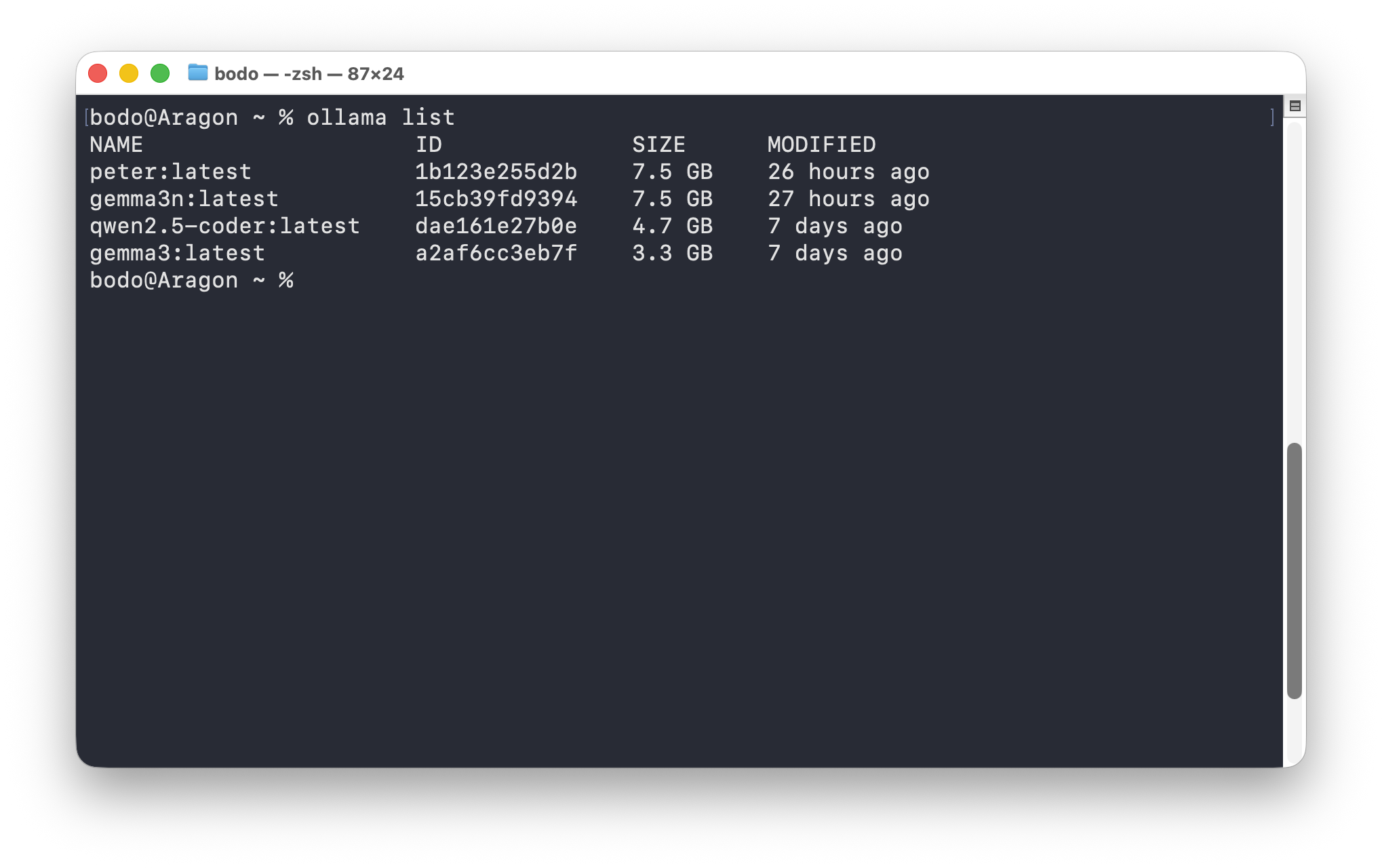

Mit Ollama können Sprachmodelle lokal genutzt werden. In diesem Artikel habe ich erklärt, wie man dieses Tool auf einem Mac installiert und Sprachmodelle für die lokale Verwendung herunterlädt. Nun möchte ich ein neues Modell vorstellen: TranslateGemma. Wie der Name erahnen lässt, lassen sich damit Texte übersetzen. Dieses Sprachmodell wurde von Google veröffentlicht, es basiert auf Gemma 3. Das Sprachmodell ist … Weiterlesen …