Dies ist nicht der erste Artikel zum Thema Künstliche Intelligenz. Bereits in früheren Artikeln, wie auch im Buch macOS-Shell für Anfänger hatte ich darüber berichtet, wobei es seinerzeit lediglich um die Alltagstauglichkeit von KI-Chatbots ging.

Beginnend mit diesem Blogbeitrag möchte ich nun jedoch tiefer in das Thema Künstliche Intelligenz einsteigen. Denn entgegen mancher Ansichten verschiedener Akteure in der Vergangenheit, ist KI nicht verschwunden, sondern nimmt stattdessen im Alltag immer mehr Raum ein, insbesondere durch KI-Chatbots. Dabei dürfte ChatGPT am weitesten verbreitet sein.

Die meisten Anwender dürften eine Online-Version — kostenlos oder als Abo — nutzen. Es besteht aber auch die Möglichkeit, ein Large Language Model (LLM) herunterzuladen. Es kann dann im Terminal oder mit einer Anwendung, die eine Benutzeroberfläche für die Eingabe bereitstellt, lokal verwendet werden.

Was ist Ollama?

Mittlerweile gibt es einige Tools, die den Prozess des Herunterladens und die Nutzung bzw. die Verwaltung der lokalen KI-Sprachmodelle vereinfachen. Ein solches Tool ist das kostenlose Programm Ollama. Es handelte sich ursprünglich um ein Kommandozeilenprogramm, d.h. es konnte nur im Terminal ausgeführt werden. Mittlerweile steht aber auch eine grafische Benutzeroberfläche zur Verfügung.

Die Terminal-App findet ihr im Ordner „Dienstprogramme“, einem Unterverzeichnis des Programme-Ordners.

> Programme > DienstprogrammeWie jedes andere Programm kann die Terminal-App auch über die Spotlight-Suche aufgerufen werden. Ein Klick auf das Lupen-Symbol in der Menüleiste oder die Tastenkombination command + Leertaste startet die Spotlight-Suche. In dem sich öffnenden Suchfeld gibt man dann „Terminal“ ein, um das entsprechende Programm zu starten. (Falls ihr mehr zum Terminal und zur Verwendung der Shell unter macOS erfahren möchtet, empfehle ich euch das bereits erwähnte Buch macOS-Shell für Anfänger.)

Ollama installieren

Bevor wir nun Ollama im Terminal nutzen können, muss dieses Programm heruntergeladen werden. Dafür ruft ihr die Internetseite des Ollama-Projekts auf und klickt auf „Download“. (Ollama ist für macOS, Linux und Windows verfügbar. Dieser Blogbeitrag behandelt die Nutzung auf dem Mac. Die Verwendung auf einem Linux- oder Windows-System ist dem aber sehr ähnlich.)

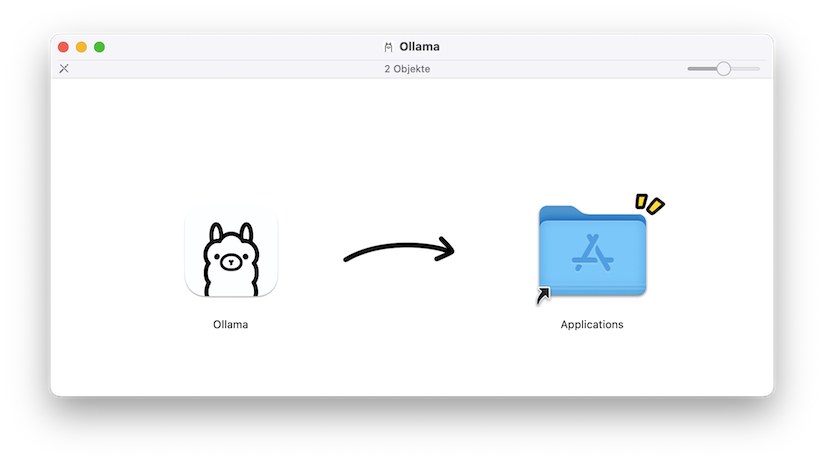

Nachdem Ollama heruntergeladen wurde, installiert ihr es auf die für macOS-Programme übliche Weise, d.h. ihr kopiert das Programm in den Programme-Ordner.

LLM mit Ollama herunterladen

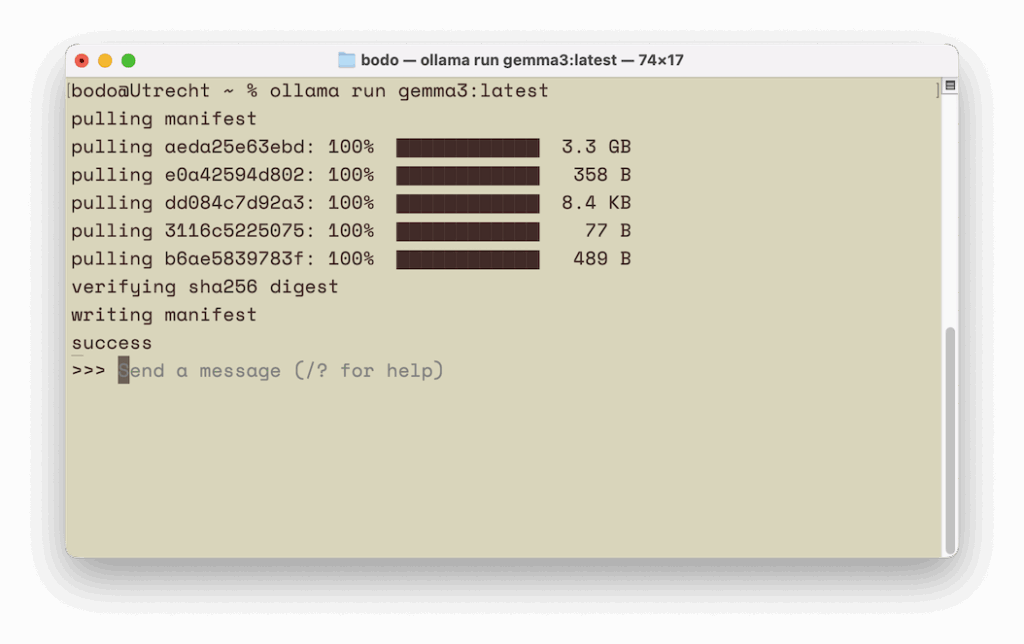

Für die Verwendung von Ollama startet ihr das Terminal (auf das Chat-Fenster gehe ich weiter unten ein). Wenn ihr dort als Befehl nur ollama eingebt, erhaltet ihr eine Übersicht zu den zur Verfügung stehenden Optionen. Die möchte ich nicht im Detail besprechen, sondern jetzt zeigen, wie man ein Large Language Model herunterladen kann. In diesem Beispiel werde ich das Modell Gemma3 von Google verwenden. Die Syntax lautet:

ollama run <KI-Modell>Möchtest man Gemma3 in der aktuellsten Version herunterladen ist also folgender Befehl zu verwenden:

ollama run gemma3:latestDabei kann „:latest“ auch weggelassen werden, da standardmäßig die neuste Version eines Modells heruntergeladen wird. Folgende Eingabe wäre also ausreichend:

ollama run gemma3KI-Modell ausführen

Durch die Ausführung des gezeigten Befehls überprüft Ollama, ob das KI-Modell bereits lokal vorhanden ist. Sollte es nicht der Fall sein, wird es heruntergeladen.

Sobald der Download beendet wurde (oder falls das Modell bereits auf dem Rechner ist), kann man hinter >>> den Text eingeben. Im Terminal wird dann die Antwort ausgegeben. Die Eingabeaufforderung kann man mit der Tastenkombination control + d oder der Eingabe von /bye wieder beenden.

Auf die gleiche Weise könnte man auch ein anderes KI-Modell herunterladen bzw. ausführen. Möchte man beispielsweise das KI-Modell von Mistral verwenden, wäre folgender Befehl einzugeben:

ollama run mistralMöchte man wissen, welche KI-Modelle bereits lokal installiert wurden, hilft folgender Befehl weiter:

ollama listDie KI-Sprachmodelle werden übrigens in einem versteckten Unterverzeichnis mit dem Namen „.ollama“ gespeichert, das sich in eurem Benutzerverzeichnis befindet:

.ollama/modelsWelche KI-Modelle gibt es?

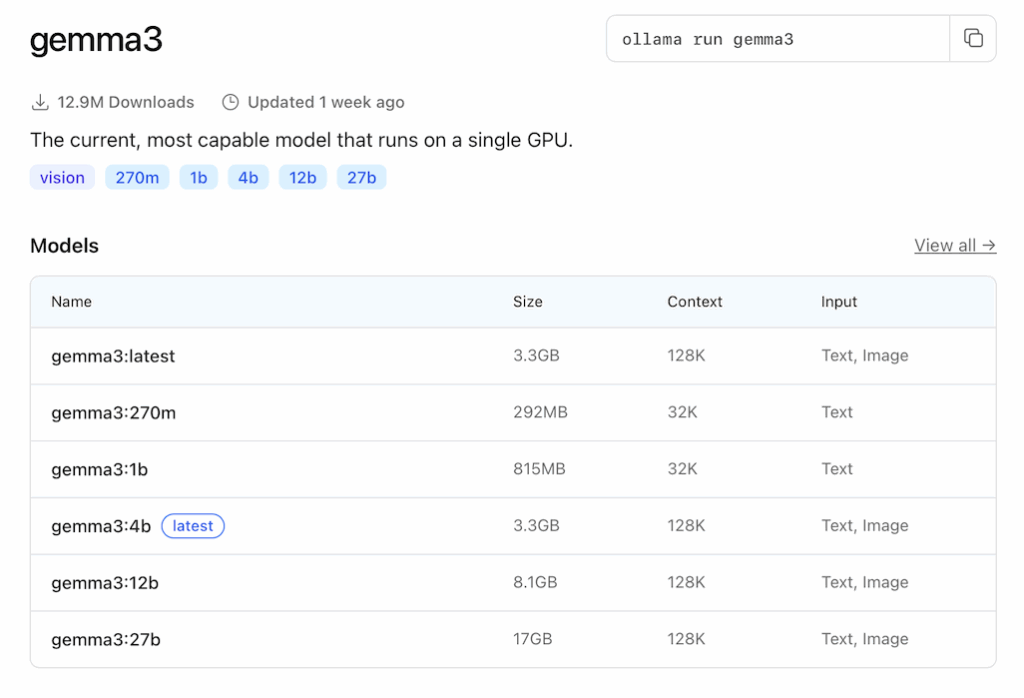

Nun kann man nicht alle Namen der für den Download zur Verfügung stehenden KI-Sprachmodelle kennen. Abhilfe schafft hier ein Blick auf die Homepage von Ollama. Denn dort werden alle zur Verfügung stehenden KI-Sprachmodelle angezeigt. Wenn ihr auf den Namen eines Sprachmodells klickt, erhaltet ihr weitere Informationen. Ihr erfahrt, welche Bezeichnung ihr angeben müsst, wenn ihr nicht die aktuellste Version eines Modell („latest“) verwenden möchtet.

Mehr Informationen zum aktuell laufenden Modell kann man übrigens im Terminal abrufen. Dazu gibt man folgendes ein:

>>> /show infoZu dem heruntergeladenen KI-Sprachmodell Gemma3 erhalte ich unter anderem folgende Info:

Model

architecture gemma3

parameters 4.3B

context length 131072

embedding length 2560

quantization Q4_K_MDie grafische Benutzeroberfläche

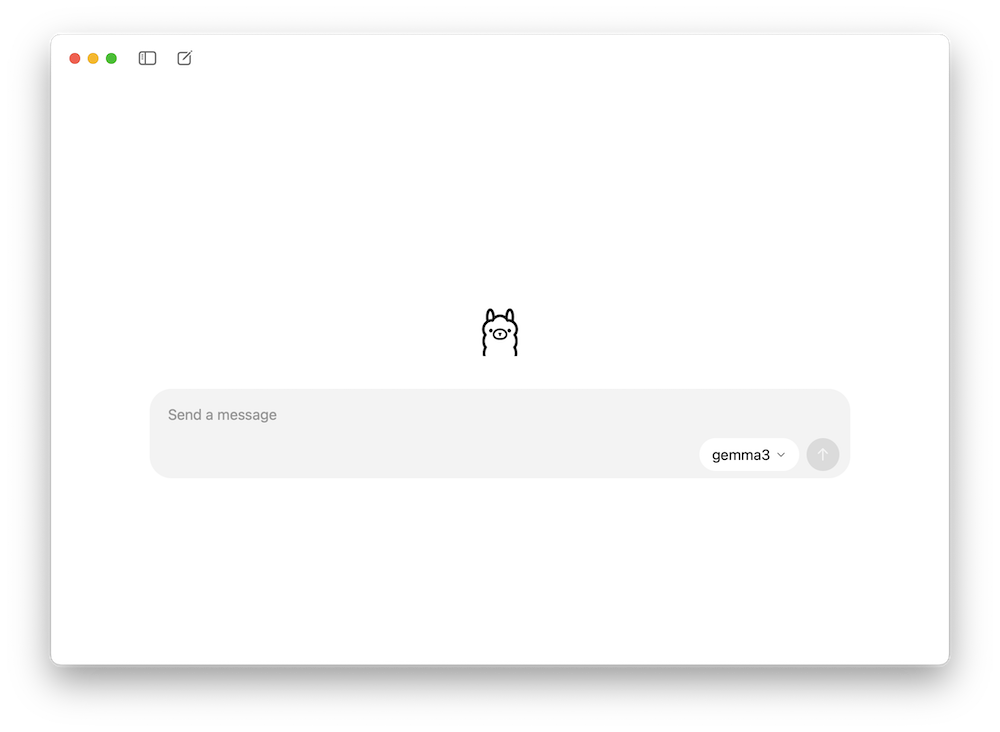

Falls ihr euch nicht mit dem Terminal auseinandersetzen möchtet, könnt ihr auch ein Chat-Fenster verwenden, das ChatGPT sehr ähnlich ist, aber weniger Funktionalität bietet.

Ihr startet dieses Fenster, indem ihr in der Menüleiste auf das Ollama-Symbol klickt und anschließend „Open Ollama“ auswählt. In dem Eingabefeld könnt ihr Text eingeben und ein Modell auswählen. Falls es nicht lokal vorhanden sein sollte, wird es heruntergeladen.

Was für einen Mac benötigt man eigentlich?

Im Grunde kann man alle Macs verwenden, die einen Apple-Chip (Apple Silicon) verwenden, also solche mit der Bezeichnung M1, M2, M3, etc. Euer Mac sollte aber über mindestens 16 GB Arbeitsspeicher verfügen, ansonsten macht die Nutzung eines lokalen KI-Sprachmodells nicht viel Freude. Bei sehr großen Modellen ist ein aktuelles Pro-Modell (z.B. M3 Pro oder M4 Pro) mit viel Arbeitsspeicher (32 GB oder mehr) sinnvoll.

Fazit

Wenn ihr mit lokalen KI-Sprachmodellen experimentieren möchtet, ist die Nutzung von Ollama ein guter Einstieg. Falls man mit der Kommandozeile — der Terminal-App — nicht vertraut ist, mag die Verwendung zunächst etwas gewöhnungsbedürftig sein. Diese Hürde sollte aber leicht zu überwinden sein, zumal man für die Nutzung und Verwaltung lokaler KI-Modelle nur sehr wenige Befehle benötigt. Und falls man nicht mit dem Terminal konfrontiert werden möchte, kann man mittlerweile auch die grafische Benutzeroberfläche verwenden, die aber sehr spartanisch daherkommt.